Одна из проблем широкого использования больших языковых моделей — авторское право. Как отличить текст, написанный человеком, от сгенерированного ИИ? И нужен ли такой анализ?

В то время как многие владельцы интернет-магазинов и другого мелкого онлайн-бизнеса всё чаще поручают создание контента машинам, «живые» тексты не теряют своей актуальности. И мы, бюро копирайтинга «Текстброкер», этому несказанно рады. И не только потому, что по-прежнему загружены работой, а потому, что нам не нравится, как пишут даже лучшие боты: скучно, однообразно, с множеством повторов, фактических, логических и стилистических ошибок.

Некоторые заказчики, предпочитающие «человеческий» контент, включают в ТЗ требования проверки на использование ИИ с помощью той или иной программы. Каждая из них обещает точно определить, сгенерирован ли текст или написан человеком.

Как это часто бывает, на волне спроса появилось множество так называемых детекторов ИИ. В этой статье попробуем разобраться, можно ли доверять их анализу.

Детекторы ИИ — принцип работы, качество проверки

Как известно, боты создают тексты преимущественно на основе ранее написанного людьми контента. Так как же детектор отличает сгенерированный текст от человеческого, если искусственный создан как раз на базе «живых»?

Алгоритм работы конкретных детекторов не разглашается, но считается, что они проводят следующие виды анализа текста:

1. Статистический

Контент ИИ обычно слишком «гладкий», с равномерной структурой без стилистических скачков. Поэтому детекторы изучают так называемую предсказуемость текста, разнообразие длины и структуры предложений.

Считается, что написанные людьми тексты менее равномерны и более хаотичны.

2. Сравнение с известными ИИ-моделями

Некоторые детекторы обучены на больших массивах контента, сгенерированного ИИ. Они ищут сходство между проверяемым текстом и паттернами, характерными для конкретных моделей (например, ChatGPT).

3. Лингвистические и стилистические маркеры

ИИ обычно использует нейтральный, «безопасный» тон, часто объясняет очевидные вещи, злоупотребляет списками и структурированными формулировками.

Детекторы пытаются выявлять такие маркеры автоматически.

Основные проблемы детекторов ИИ

1. Высокий процент ошибок

Ложные срабатывания: тексты, написанные людьми, могут быть ошибочно помечены как ИИ.

Пропуски: слегка отредактированный ИИ-текст часто проходит проверку как «человеческий».

Ни один детектор не даёт 100% точности. Более того, они так часто ошибаются, что не заслуживают никакого доверия.

2. Быстрое устаревание

ИИ-модели развиваются быстрее, чем детекторы. Новые версии генераторов пишут более вариативно и естественно, из-за чего старые методы анализа перестают работать.

Вывод

Итак, алгоритм работы детекторов несовершенен и любую проверку легко обойти. Поэтому эти сервисы ненадёжны и даже вредны. Чего только стоит определение текста сгенерированным, если он логичен и хорошо структурирован?! По логике машины, контент от опытного автора более искусственен, чем творение начинающего копирайтера, который понадергал отрывков из разных источников, слегка их отрерайтив для уникальности, и строчит «простыни», забыв о структуре текста.

Тестируем популярные сервисы проверки

Выше мы разобрали теоретические аспекты работы детекторов. Но опыт лучше любых рассуждений, поэтому мы решили протестировать несколько раскрученных сервисов. И обнаружили, как и предполагалось, что разные программы кардинально расходятся во мнении при проверке одного и того же контента, часто считают «живые» тексты сгенерированными и наоборот.

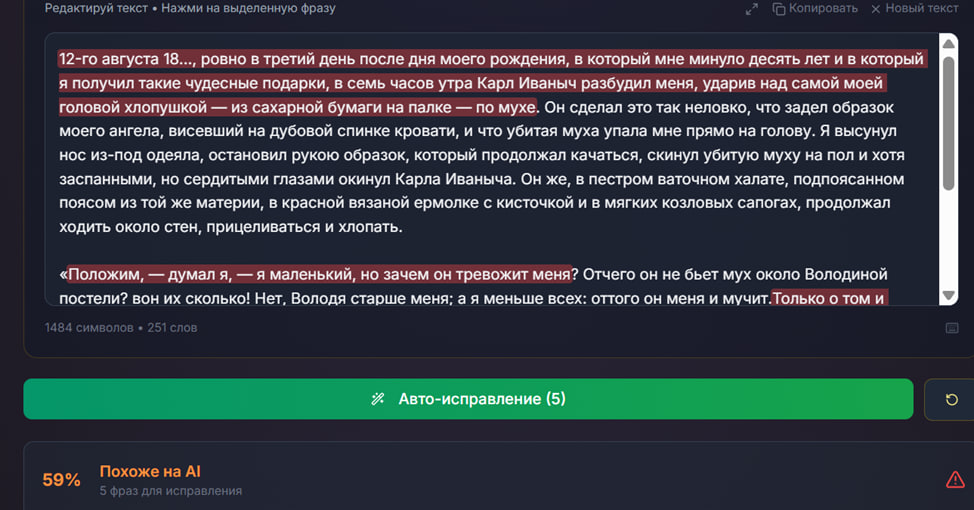

Более того, многие популярные детекторы считают искусственными даже тексты классиков литературы. И тут же предлагают «очеловечить» контент — обычно за дополнительную плату. Вот одна из таких программ, заточенная, как говорят, под проверку статей для Дзена. Мы предложили ей протестировать начало «Детства» Л. Н. Толстого. Вот, что получилось:

И тут же сервис даёт рекомендации:

Бедный Лев Николаевич)) Детекторы не любят, как мы уже знаем, хорошо структурированные, грамотные и логичные тексты, и по-прежнему, начиная с самых первых моделей, подозрительно относится к тире. Машина считает, что человек не может хорошо писать? Даже как-то обидно)) Кстати, на этом основан способ обойти проверку, который давно используют студенты: добавить ненужные запятые, парочку орфографических ошибок.

Возможно, нам просто попался некачественный детектор?

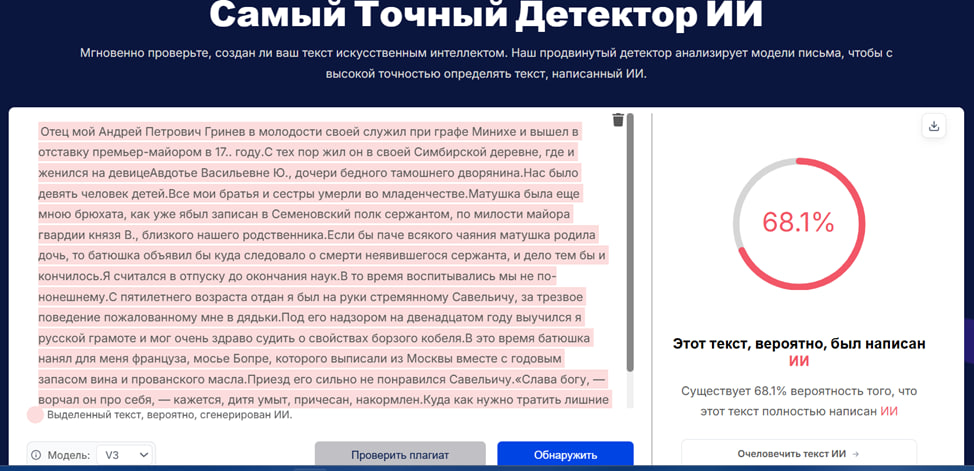

Но нет, вот ещё один, где вероятность использования ИИ даже выше:

Справедливости ради скажем: несколько сервисов всё же посчитали Толстого человеком, а некоторые нашли 2–4% процента якобы сгенерированных отрывков — по только им ведомому алгоритму. Означает ли это, что эти детекторы всё же способны работать адекватно? Или в них просто загружен больший массив данных, позволяющий определять произведения известных авторов? Вопрос риторический.

Что думают об определении сгенерированных текстов специалисты

Компьютерный лингвист, адъюнкт-профессор, лектор Хельсинкского университета Михаил Копотев, много лет занимающийся выявлением плагиата, считает, что сейчас нет четких критериев, позволяющих определить авторство посредственных, банальных текстов. Разве что у роботов меньше грамматических ошибок.

Яркий, креативный, оригинальный контент машине пока не по зубам, ведь нейросети способны обучаться лишь на созданном людьми контенте, а когда его недостаточно, используют сгенерированные самостоятельно синтетические данные.

Но копирайтерам чаще всего заказывают обычные статьи, не требующие от авторов яркого писательского таланта. И детекторы неспособны достоверно отличить обычный информационный или аналитический текст от сгенерированного.

Так что же делать заказчикам, предпочитающим «живые» тексты? Мы собрали несколько советов от специалистов: на что стоит обратить внимание при анализе контента.

Профессионалы отмечают главные недостатки ботов: плохое понимание контекста, отсутствие творческого мышления и критического анализа.

Именно поэтому сгенерированные тексты обычно скучны и шаблонны, в них присутствуют повторы и клише, логические и фактологические ошибки, зато отсутствует глубина и оригинальность. Если машина обучена на SEO-текстах, в контенте будет переизбыток однотипных слов и фраз.

Другими словами, если текст плох, скучен и однообразен, слова написаны грамотно, но есть другие ошибки, повторы одних и тех же мыслей, то он вполне может быть сгенерированным. Ну или просто его написал неопытный копирайтер.

Парадоксально, что у некоторых заказчиков вызывают подозрения отличные статьи. Авторы получают такие комментарии: текст «уж слишком хорош, слишком грамотный, идеально структурированный». Спешим успокоить заказчиков: наши авторы пишут намного лучше ботов. И если вы получили логичный, легкочитаемый, убедительный контент без стилистических, логических и других ошибок, то он почти наверняка написан человеком.